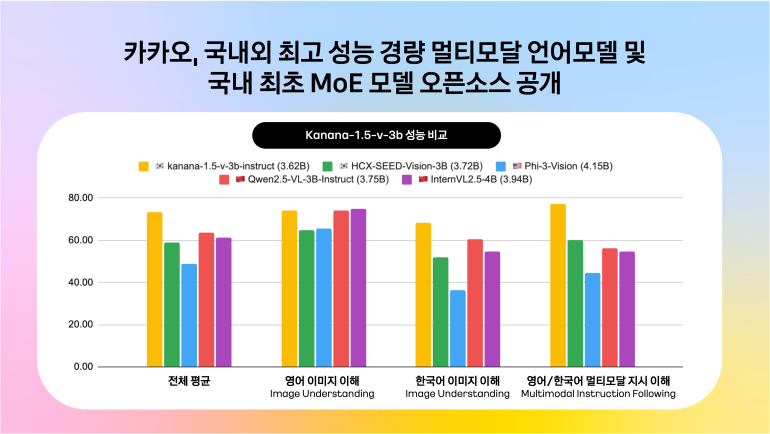

카카오, 국내 최고 성능 경량 멀티모달·MoE AI 모델 동시 공개

이미지·텍스트 이해 가능한 ‘Kanana-1.5-v-3b’와 고효율 MoE 모델 ‘Kanana-1.5-15.7b-a3b’ 오픈소스 공개

(씨넷코리아=김태훈 기자) 카카오에서 국내 최고 수준의 경량 멀티모달 언어모델과 효율성을 극대화한 MoE(Mixture of Experts) 모델을 동시 공개했다.

카카오는 24일, 글로벌 AI 개발자 커뮤니티인 ‘허깅페이스(Hugging Face)’를 통해 ▲이미지와 텍스트를 함께 이해하고 지시를 이행할 수 있는 경량 멀티모달 모델 ‘Kanana-1.5-v-3b’와 ▲고성능·고효율 MoE 언어모델 ‘Kanana-1.5-15.7b-a3b’를 오픈소스로 공개했다고 밝혔다.

Kanana-1.5-v-3b는 지난 5월 공개된 카카오 자체 개발 LLM(대규모 언어모델) ‘Kanana 1.5’ 시리즈를 기반으로 이미지와 텍스트를 모두 이해할 수 있는 능력을 갖춘 경량 멀티모달 모델이다. 국내외 유사 모델 대비 한국어·영어 이미지 인식과 지시 수행 성능이 뛰어나 GPT-4o 수준에 근접하거나 상회한다는 평가를 받고 있다.

특히 이 모델은 사람이 선호하는 방식으로 응답하도록 학습된 ‘Human Preference Alignment Training’과 고성능 대형 모델의 지식을 소형 모델에 전수하는 ‘지식 증류’ 방식을 통해, 상대적으로 가벼운 구조임에도 불구하고 정교한 추론 능력을 갖췄다. 실제로 문서 해석, 시 창작, 문화유산 인식, 수학 문제 풀이 등 다양한 분야에서 즉각적인 활용이 가능하다.

한편, 함께 공개된 Kanana-1.5-15.7b-a3b는 최근 AI 업계의 새로운 트렌드로 주목받는 MoE 구조를 적용한 언어모델이다. 전체 15.7B 파라미터 중 약 3B만 활성화돼 작동하는 구조로, 효율성과 성능을 동시에 확보했다. 기존 모델을 재활용하는 ‘업사이클링’ 방식으로 개발돼 학습 비용과 시간을 절감했으며, 카카오의 8B 모델과 동급 이상의 성능을 기록한 것으로 알려졌다.

카카오는 이번 두 모델 공개로 국내 AI 모델 오픈소스 생태계에 새로운 이정표를 제시하고, 더 많은 연구자와 스타트업이 자율적으로 국산 LLM을 실험하고 활용할 수 있도록 아파치 2.0 라이선스를 적용했다. 향후에는 추론 중심의 에이전트형 AI 모델도 공개할 계획이다.

김병학 카카오 카나나 성과리더는 “이번 오픈소스 공개는 단순한 성능 개선을 넘어, 비용 효율성과 기술 자립이라는 두 측면에서 의미 있는 진전을 이뤘다”며 “앞으로도 초거대 AI 모델 개발 등 국내 AI 경쟁력 강화에 기여할 것”이라고 밝혔다.